Metaの「LIama2」が日本語化。東大発のAIスタートアップが開発・公開!

近年の大規模言語モデル(LLM:Large Language Model)の発展は目覚ましい進歩を遂げています。代表的なもので言えば、Chat-GPTは一般の人が私的かつ簡単に利用できるので、使用したことのある人も多いのではないでしょうか。この記事ではそんな大規模言語モデルの一つであるMeta社の「Llama2」が日本語化されたことについて説明していきます。

この記事を読むと以下の2つのことがわかります。

(1)東大発スタートアップがMetaのLIama2を日本語化

(2)ELYZAが公開したモデル

(3)ELYZAの展望

東大発スタートアップがMetaの「LIama2」を日本語化

まず最初にMetaの「LIama2」について簡単にご紹介します。

MetaのLIama2とは

Llama2とは、2023年7月にMetaが研究と商用向けに無償で提供し始めたオープンソース大規模言語モデルのことです。

モデルサイズは70億、130億、700億パラメータの3種類があります。また、事前学習バージョンと会話型ファインチューニング・バージョンのモデルウェイトとスターティング・コードが含まれています。

公開されているモデルの中でも高性能で、クローズドなモデルであるOpenAIのGPT-4やGoogleのPaLMと競合を行っています。英語圏ではオープンモデルのデファクトスタンダードとなってきています。

LIama2を日本語対応化

2023年8月、東京大学松尾研究室発のAIスタートアップであるELYZAが、「Llama 2」ベースの商用利用可能な日本語対応の大規模言語モデル「ELYZA-japanese-Llama-2-7b」を一般公開しました。

これと同時に

・ELYZA独自の事後学習を施した「ELYZA-japanese-Llama-2-7b-instruct」

・日本語の語彙追加により高速化を行った「ELYZA-japanese-Llama-2-7b-fast / ELYZA-japanese-Llama-2-7b-fast-instruct」

の2つも公開されました。

これらはLlama2の70億パラメータのモデルに日本語で追加学習を行って開発したものです。あとでこれらの詳細についてご紹介します。

ライセンスはLlama 2 Community License に準拠しており、Acceptable Use Policy に従う限りにおいては、研究および商業目的での利用が可能です。※1

「Llama2」日本語対応化の背景

日本でも複数の企業で大規模言語モデルの開発に取り組んでいますが、実用化するには不十分な性能に止まっているのが現状です。これは日本語で利用できるテキストデータや計算リソースの少なさによるものです。また、一から大規模言語モデルの事前学習を行うには膨大なコストがかかるために取り組みにくい研究でもありました。

そこでELYZAでは、他言語で学習されたモデルを日本語に引き継ぐことで、日本語による学習量を減らし、上で挙げたような課題を解決しました。

ELYZAが公開したモデルと性能

次にELYZAが公開したモデルの詳しい内容について解説します。

ELYZAが公開したモデル

・「ELYZA-japanese-Llama-2-7b」

MetaのLlama-2-7b-chatに対して、180億トークンの日本語テキストで追加事前学習を行ったモデル。

Wikipediaなどを日本語テキストデータとして学習に用いました。

・「ELYZA-japanese-Llama-2-7b-instruct」

ユーザーからの指示に従ってタスクを解くことを目的として、上記の「ELYZA-japanese-Llama-2-7b」に対して事後学習を行ったモデル。

事後学習には、ELYZA独自の高品質な指示データセットを使用しており、複数ターンの対話にも対応することが可能になっています。

・「ELYZA-japanese-Llama-2-7b-fast / ELYZA-japanese-Llama-2-7b-fast-instruct」

Llama 2に日本語の語彙を追加して事前学習を行ったモデル。

元のLlama 2は日本語の語彙が少ないため、日本語の文章を表現するのに英語と比べて多くのトークン数を必要としていました。その結果、入出力できる文章量が短くなってしまうという問題と推論速度が遅いという問題が生じていました。

そこで、新たに13,042個の日本語の語彙を追加することで、同じ日本語の文章を表すのに必要なトークン数を、約55%まで削減することができています。推論速度に換算すると約1.82倍となっており、大幅な効率化に成功しました。

「ELYZA-japanese-Llama-2-7b-fast-instruct」はELYZA-japanese-Llama-2-7b-fastに対して事後学習を行ったものです。

モデルの性能

ELYZAが独自に行った性能評価によると、他の日本語の公開モデルと比較して最も高いスコアを記録しました。他の日本語モデルと比較すると学習している日本語のトークン数が少ないにもかかわらず、高い性能となっています。速度を重視したモデルであるELYZA-japanese-Llama-2-7b-fast-instruct についても、ELYZA-japanese-Llama-2-7b-instructと同程度のスコアを獲得しています。

しかしながら、OpenAIのGPT-4やGPT-3.5-turbo、GoogleのPaLMなどのクローズドな大規模言語モデルと比較すると低い性能となっており、今後の改善が楽しみですね。

利用方法

先ほども述べたように、公開したモデルのライセンスはLlama 2 Community Licenseに準じており、研究および商業目的での利用が可能です。

これら4つのモデルはHugging Face Hubで公開されており、transformersライブラリより利用することができます。

ELYZAの展望

今回ご紹介した、日本語版のLlama2は70億パラメータのモデルを利用したものですが、2023年10月現在は130億、700億パラメータのモデルについても開発を進行中とのこと。そしてそれらについても公開を検討しているようです。

ELYZA, Inc.のnoteでは技術ブログではLlama 2を日本語化するなかで得られた知見やノウハウについての記事などがあげられています。これらを共有する目的は研究室やスタートアップ、個人などでも日本語の大規模言語モデルの研究開発に取り組める環境を作り上げることにあるそうです。

まとめ

Chat-GPTをはじめとした大規模言語モデルというのは企業だけでなく、私たちの生活にとって欠かせないものになってきています。そうした最新技術を日本語で利用できることは私たちの生活をますます便利にしています。ELYZAの共有した知見やノウハウがきっかけとなって日本語の大規模言語モデルの研究が加速し、発展していくのが楽しみですね。

大手ゼネコンBIM活用事例と 建設業界のDXについてまとめた ホワイトペーパー配布中!

❶大手ゼネコンのBIM活用事例

❷BIMを活かすためのツール紹介

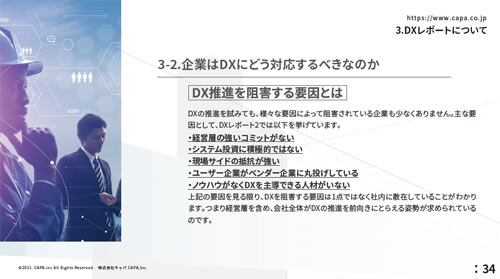

❸DXレポートについて

❹建設業界におけるDX

※1 ELYZA, Inc.『Metaの「Llama 2」をベースとした商用利用可能な日本語LLM「ELYZA-japanese-Llama-2-7b」を公開しました』

https://note.com/elyza/n/na405acaca130