進化を続ける生成AI_Metaが発表した「CM3leon」とは

ジェネレーティブAIの中でも、画像生成AIの進化は凄まじく、今や簡単なアニメーションぐらいであれば作成できるようになってきました。テキストプロンプトで指定すると、まるで写真のようなリアルな画像を生成し、そこからアニメーションに加工するという手順です。

最近になってMetaが新たな手法を用いたさらに進化した画像生成AIを発表し、話題なっています。

この記事でわかること

・Metaが発表した「CM3leon」の特徴

・画像生成AIに使われている技術

・Metaが目指すメタバース

Metaが発表した「CM3leon」の特徴について

まず「CM3leon」読み方ですが、これ「カメレオン」と読むそうです。ハッカー文化の一つ、LEET文と呼ばれるもので、「e」を「3」に変えるなど似た形状の数値や記号に置き換えています。

他にも「for」を「4」に、「to」を「2」になど、音が似ている数値に変えたり、「you」を「u」に短縮して表現したりもします。ハッカー独自の文化から、今では一般の若者でも使うようになっています。

しかし、カメレオンってスペルは”chameleon”です。「CM3leon」をLEET文で表すと”cmeleon”となり、スペルがちがいます。

ちなみに「CM3」は「因果マスク混合モーダル」モデルを意味しており、「CM3leon」はこの技術をベースに構築されています。多分、Metaの技術者が「いいこと思いついた!」ぐらいのノリで「カメレオン」とネーミングしたのではないでしょうか。

「CM3leon」の特徴として、テキスト入力から画像を生成(Text to Image)するだけではなく、画像からテキストを生成することもできる点が挙げられます。指定した画像に対する説明やキャプションなどを生成することも可能であり、他の画像生成AIと比較しても幅広い用途に活用できます。

また「CM3leon」は、テキストと画像の両方を含むマルチモーダル文章で学習した生成モデルである「CM3」をベースとしています。その上で細かなチューニングがされているため、画像・テキストの両方を理解します。

そのことにより、複雑な構成のオブジェクト・テキストプロンプトに対応した生成を実現していることが大きな特徴です。

多くの画像生成AIでは、大量の画像をソースとして学習するAIと文章を理解するAIが連携することで「Text to Image」を実現しているため、「CM3leon」とは大きく異なる点と言えます。

「CM3leon」は、初めから画像とテキストの両方の情報を学習用のリソースとして使っているため、画像の持つ意味やテキストでの表現に優位性があるということではないでしょうか。

また、既存のトランスフォーマーベースの手法を使ったAIよりも、5倍も少ない計算量でありながら、最先端のAIにも負けない性能を持っているとのことです。あるベンチマークテストでは、Googleの画像生成AI「Parti」の性能を上回ると報告されています。

「CM3leon」は、例えば基準となる画像に対して「画像の一部に修正を加える」などをテキストで指示し、実行させることができます。これは画像を構成するそれぞれのパーツが何かを理解した上で、適切な修正が可能であるからこそできることです。

他の画像生成AIでは、このような細かな修正・加工が難しいものも多く、「CM3leon」が進化したモデルであることを物語っています。

また、一から画像を生成する際にも、「サハラ砂漠で麦わら帽子をかぶり、サングラスをかけた小さなサボテン」といったプロンプト入力に対して、非常に正確で写実的な結果を出力します。

他にも「侍の刀で壮大な戦いに備えるアニメのアライグマの主人公、戦闘態勢、ファンタジー、イラスト」にと言うテキストに対して、まるでハリウッド映画に登場するキャラクターを思わせる画像出力の例が紹介されています。

これまでの画像生成AIでは、このような細かな指示に正確に対応させることが難しく、出力結果を見てプロンプトの指示などを細かにチューニングする必要がありました。

Metaによって紹介されている「CM3leon」の事例を見る限り、目的とする画像を生成するまでの手間は大幅に削減できる可能性が高いと思われます。おそらく2024年1月時点で、最も進化した画像生成AIの一つと判断して良いでしょう。*注1

画像生成AIに使われている技術について

ここでは、画像生成AIに使われている技術について、簡単に概略を紹介していきましょう。

初期の画像生成AIに利用されていたのは、「GAN(敵対的生成ネットワーク)」という技術です。

これはAIのトレーニングに使われる手法の一つですが、非常に写実的で精巧な画像を作成することが可能です。その一方で、応用が苦手で多様性に乏しいというデメリットがあるため、現在は主力とはなっていません。

「GAN」で用いられる手法は、わかりやすく言い換えると「先生と生徒」を準備して、それぞれが学習することでレベルをアップしていくというものです。生徒役のAIが画像を作成し、先生役のAIがそれをチェック、拙いところを指摘して修正を促します。先生AIは現実の画像を見本として、生徒AIの作成した画像を評価していきます。

この過程を繰り返すことによって、生徒AIは徐々に現実に近い画像を生成するように進化します。同時に先生AIも繰り返し画像の比較をすることで、細かな間違いにも気づくようになり「チェック能力=指導力」が向上するというものです。

現実の師弟関係のように、お互いに刺激しながらスキルを磨いていくモデルです。

しかしこの師弟関係は、一人の先生・一人の生徒だけしか存在しない「閉じた世界」です。そのため、トレーニングするほどに生成する画像のタイプや傾向が固定化するようになり、幅広いバリエーションに対応できなくなってしまいます。

例えると、日本画家に師事した弟子の場合、その道では素晴らしい作品を制作できるが、油絵は全然ダメみたいなイメージでしょうか。

このような自由度の低さから、「GAN」以外の手法が多く用いられるようになりました。

現在の画像生成AIで主流となっているのは、「拡散モデル」と呼ばれるものです。

「拡散モデル」は、最初にサンプルとなる画像に対してノイズを加えることで、少しずつ破壊していく過程をAIに学ばせます。その後完全に破壊され、もはや原型を無くしてしまった「ただのノイズ」から、元画像への復元をさせるというものです。

一見するとファイルの圧縮・復元に似ているように思えますが、大きく異なる点があります。ファイルの圧縮・復元では「冗長なデータをまとめることで、ファイルサイズを圧縮する」という点が本質であり、最初のファイルが持つ本質的なデータは維持されています。

それに対して「拡散モデル」の場合、元のデータはほぼ完全に破壊されており、必要な情報が失われている状態から復元を試みます。低解像度の画像を高解像度にするために、必要なデータを周辺の色から近似するような手法とも全く異なります。ノイズしかない画像にいくら近似色で補完しても、結果はノイズにしかなりません。

画像が破壊されデータが失われていく過程を学ぶことで、ノイズの除去(逆拡散過程)をAIが推理しながら新しく画像を生成していきます。これはゼロから画像を生み出すことと遜色ない状態であり、画像の持つ意味や特徴を理解しているとも捉えることができます。

例えていうなら、「彫刻の達人が、一本の木材を観察し、木目や材質などの特徴を見極めた上で、最高の作品を掘り出す」ようなイメージです。ただのノイズにしか見えない画像であっても、「拡散モデル」でトレーニングされたAIならば、そこから一枚の意味のある画像に変換してしまいます。

「拡散モデル」は、生成元となるノイズに少し変更を加えるだけで、AIは全く異なる新しい画像を生成できるという特徴があります。このため、少しの手間で大量の異なる画像を次々に生み出すことが可能になり、自由度や応用の高さは「GAN」を大きく上回ります。

ここまでは、画像生成AIのベースとなる技術についてわかりやすいイメージで紹介してきました。いままでのAIであれば、さらにテキスト入力に対応させるために、もうワンステップ必要となります。

「CM3leon」は、初めから画像とテキストを融合したサンプルで学習させた、「画像に含まれる意味をテキストベースで理解するAI」であることが、既存のものと大きく異なります。*注2

Metaが目指すのはメタバースにおける創造性の向上

「CM3leon」が学習用に利用した画像データは、Shutterstockのライセンス画像に限られています。他の画像生成AIが、インターネット上にある無数の画像データを利用しているのに比べ、著作権・所有権・肖像権などの権利に抵触することがなく、法的な問題を回避しています。

また、メタバースという新たなフィールドの開発・普及に社運をかけているMetaにとって、「CM3leon」は「メタバースにおける創造性を高める」ためのツールという位置付けです。Metaは同時に、マルチモーダル言語モデルを探求することで、今後さらに多くのモデルをリリースする予定であると発表しています。

OpenAIの「DALL-E」やStability AIの「Stable Diffusion」など、先行する画像生成AIに追従し、技術的にはより進化したモデルをMetaが発表したことで、この分野の競争は今後も激化していくことでしょう。

Metaの「CM3leon」は、現在まだ研究段階とのことですが、非常に魅力的な性能を有していることから、早めの製品化を期待したいものです。*注3

【まとめ】

静かに目を閉じ、風の囁きや小川の流れに耳を傾けていた芸術家が、突然ひらめきを得て筆を持ち、瞬く間に素晴らしい芸術作品を仕上げていく。拡散モデルの逆拡散過程におけるAIは、まさにこのようなイメージで動いているように思えます。

半世紀ぐらい後の芸術家の仕事は「どのような指示をAIに出すか」であり、自分の手を動かすことがなくなっているのかもしれません。

大手ゼネコンBIM活用事例と 建設業界のDXについてまとめた ホワイトペーパー配布中!

❶大手ゼネコンのBIM活用事例

❷BIMを活かすためのツール紹介

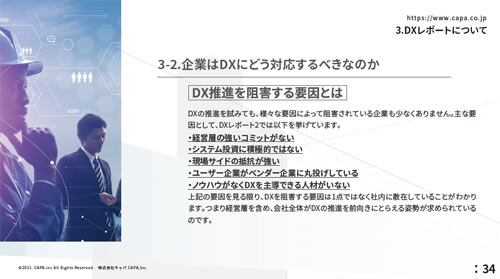

❸DXレポートについて

❹建設業界におけるDX

■参考文献

注1

Impress Watch 「Meta、テキスト・画像の双方の生成に対応したAIモデル「CM3leon」」

https://www.watch.impress.co.jp/docs/news/1516872.html

BRIGDE 「Meta、文言から画像を生成する新ジェネレーティブAI「CM3leon(カメレオン)」を発表」

https://thebridge.jp/2023/07/meta-reveals-new-ai-image-generation-model-cm3leon-touting-greater-efficiency知財図鑑 「Meta、テキストから画像・画像からテキストの両方を生成するAI「CM3leon」発表―自己回帰モデルの可能性を拡張」

https://chizaizukan.com/news/3Z2ux30KD4bYlyW7TTdopi/注2

Vneture Beat ”How diffusion models unlock new possibilities for generative creativity”

ビジネス+IT 「拡散モデルとは?Stable Diffusionなど「画像生成AIの学習モデル」をわかりやすく解説」

https://www.sbbit.jp/article/cont1/128789

AWS 「自己回帰モデルとは?」

https://aws.amazon.com/jp/what-is/autoregressive-models/

zero to one 「自己回帰モデル (AR)」

https://zero2one.jp/ai-word/autoregressive-mode

CodeZine 「「Transformer」の仕組み──AIによる画像・動画生成や自然言語処理で話題の深層学習モデルを理解する」

https://codezine.jp/article/detail/16860?p=3

注3

Dream Studio ”Dream Studio Terms of Service”

https://dreamstudio.ai/terms-of-service

OpenAI “Terms & policies”

TOKOTONブログ 「画像生成AIサイト9種類を比較!それぞれの特徴とは?」

https://tokoton.biz/blog/image-generation-ai-website/#i-10