AppleのNeuralHashで画像を調べる仕組みとは?

CSAM(児童性的虐待コンテンツ)は、一度インターネット上に情報が流れてしまうと削除などの対応が難しいという課題があります。

そこでAppleでは、子どもを性被害から守るための仕組みをいくつか導入しているのです。

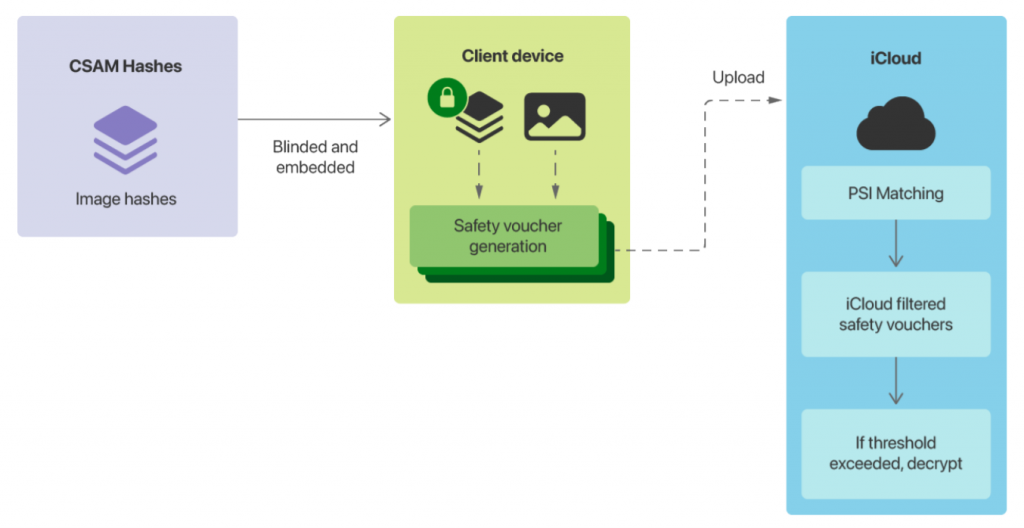

NeuralHashはAppleが新しく発表した技術で、ユーザー端末上で駆動してiCloud上のCSAM画像を検出します。

この記事ではNeuralHashとはどのような技術なのかについて、CSAMの現状やAppleのCSAM対策技術とあわせて解説します。

児童ポルノは製造や所有が規制の対象

ここではAppleがNeuralHashを開発するきっかけとなったCSAM(Child Sexual Abuse Material:児童性的虐待コンテンツ)の現状について解説します。

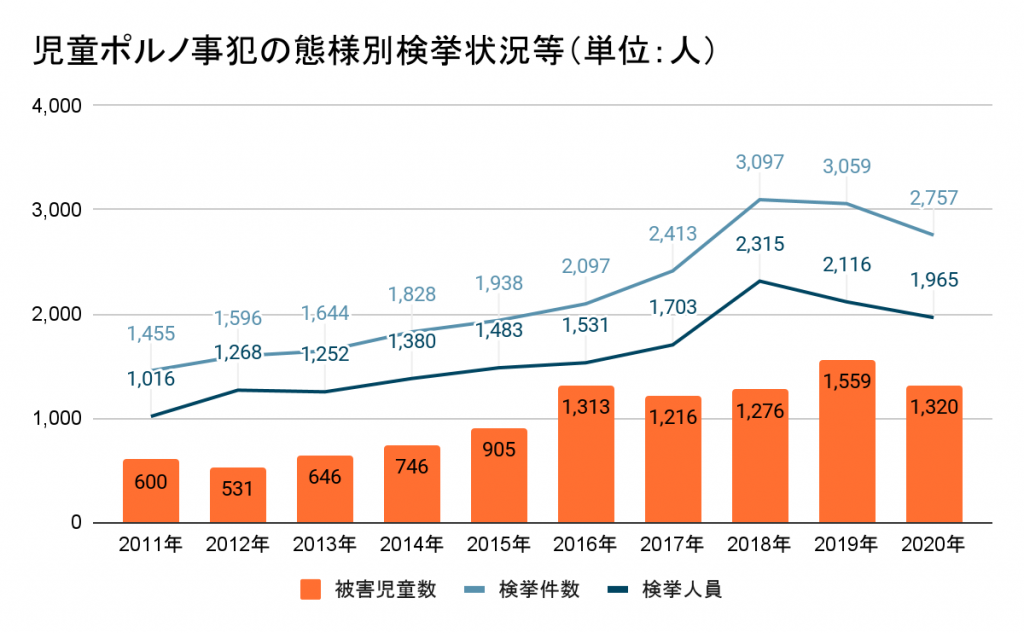

児童ポルノに関する事件が増加している

インターネットが身近に利用できるようになった一方で、国内ではさまざまな児童ポルノに関する事件が起きています。

例えば、小中高生がだまされたり脅されたりして自ら自分を撮影し、裸の画像などを第三者に送らされるといった被害が挙げられます。

また、成人をあたかも子どもに見えるように装ったコンテンツやリアルなCGなどが児童ポルノに関わる犯罪を誘発しているという主張があります。

それらは児童ポルノには抵触しませんし、実際に子どもが性被害にあうわけでもありません。

しかし子どもを性の対象としてみてしまう認知のゆがみを引き起こす要因になっているのです。

若者や未成年者は、性的虐待や搾取の危険から保護しなければなりません。

しかし、国内の児童ポルノ事件に限っても、子どもの性被害は年々増えている状況です。

児童買春等の被害児童数はやや減少がみられるものの、児童ポルノ被害児童は増加傾向にあり深刻な状況が続いています。

児童ポルノ規制に関する法制度

国内に限らず、世界的に児童ポルノは規制する対象と考えられています。

子どもの権利を守る動きのなか、2000年に国連総会で「児童の売買等に関する児童の権利条約選択議定書」が採択されました。

これにより締約国において、児童ポルノの製造や配布などの目的で保有すると罪に問えると合意されたのです。

さらに2001年には国越をまたいだコンピュータ犯罪やサイバー攻撃に対応するために「サイバー犯罪に関する条約」が国際条約として採択されました。

インターネット上に児童ポルノ画像等をアップロードすることは、法律に抵触する犯罪です。

子どもを性被害から守るためには、自身の判断によりアクセス権限を付与するフィルタリングが有効です。

また、Appleでは製品やサービスを安心して利用してもらえるようにNeuralHashなどのCSAM保護機能を開発するに至ったといえます。

AppleのCSAMへの対応状況

子ども自身が意図せず性的なコンテンツに触れてしまう場合があります。

そこでAppleでは、子どもをCSAMコンテンツから守るために複数の対応を行っています。

メッセージの送受信制限

ファミリー向けの機能として、子どもがiMessegeのアプリを使って性的に問題な可能性があると判断された画像を見ようとした場合に規制する機能があります。

AppleのiMessegeでは、子どもが性的に問題のある画像を送受信しようとした場合に以下のような対応をします。

・画像の表示をぼかす

・画像を表示させようとした場合に、警告メッセージが表示される

・保護者に閲覧を報告するメッセージが送付される

Siriや検索の強化

Appleユーザーが、CSAMに関連する単語をSiriや検索入力しようとした場合に以下のような警告が出されます。

悪質なコンテンツの報告を促すなど、ヘルプラインとガイダンスへ誘導できるようになっています。

メッセージ例

・オンラインでの児童搾取を報告するシステムがある

・児童虐待を描いたマテリアルは違法です

NeuralHashは児童虐待画像を自動検出する技術

NeuralHashはAppleのCSAM保護施策のひとつです。

NeuralHashとはどのような技術なのかさらに詳しくご紹介します。(*1)(*2)

NeuralHashは児童虐待画像を自動検出する

NeuralHashとはAppleが独自に開発したハッシュ技術のひとつです。

ハッシュ化とは、パスワードの保管などによく用いられる方法で、もともとのデータから一定の計算手順に従いハッシュ値と呼ばれる規則性のない値を求めて元のデータを置き換える仕組みです。

NeuralHashは、iCloud Photosを介してCSAMにあたる画像が拡散しないようにするようアップロードされた画像を監視します。

ある画像がiCloudにアップロードされる際に何がCSAMにあたるのか判断する情報源として各ユーザーのデバイス上でCSAMハッシュを用います。

そして、ユーザーが児童虐待や児童ポルノにあたる画像がiCloudにアップロードしたことを検出し、一定の条件を満たした場合にはユーザーの個人情報を守りながら警察機関に通報できるようになっているのです。

NeuralHashは欠陥が指摘されている

NeuralHashの技術を活用すると、ハッシュの設定のしかたによってはCSAMの対象でないものもCSAMの画像だと検出してしまう場合があります。

実際にある研究者が、犬の写真と灰色の画像を用いて実験した結果、対象外の画像まで検出してしまう状況が確認できたとしています。

何がCSAMにあたるのかユーザーは確認できないため、不当に通報されてしまう恐れがあるのです。

また、ハッシュをCSAMに設定すればCSAMの画像が検出できますが、ハッシュが任意の情報であっても対象となる画像が検出できることになります。

つまり各ユーザーの端末に保存されているどんな画像でもAppleの権限だけで探せることになるため、プライバシーの侵害として大きな問題となる懸念があるのです。

ハッシュ技術自体はApple以外でも使われている技術であり、iCloudにアップロードされた画像に関する調査であればそれほどの問題はないかもしれません。

しかし、各デバイスにあるデータも勝手に調べられるかもしれないとなると、抵抗があるのも当然だと言えるでしょう。

AppleはNeuralHashの導入延期を決定

Appleは安全性とプライバシー重視の姿勢を強調していますが、どこを優先に開発するのは難しいところです。

NeuralHashを強制導入しても他に不正アクセスに繋がるセキュリティの脆弱性があれば適切に対応しきれているとは言えません。

さまざまな指摘を踏まえ、AppleではNeuralHashを正式リリースする前に、さらに時間をかけて意見を収集し機能の改善を図るとして導入の延期を決定しました。

再導入の予定は未定ですが、今後CSAMコンテンツに対する規制はさらに厳しくなると考えられます。

まとめ

児童が児童ポルノ犯罪に巻き込まれる事件は日々増加しています。

Appleでは性的虐待CSAMコンテンツを規制するためにNeuralHashの導入を決定したのです。

しかしプライバシーの保護やセキュリティとのバランス非常に難しく、慎重な検討が行われています。

再度検討したうえでリリースされる可能性がありますが、ユーザーとしても不適切なデータを閲覧・所持・取得しないよう注意が必要です。

大手ゼネコンBIM活用事例と 建設業界のDXについてまとめた ホワイトペーパー配布中!

❶大手ゼネコンのBIM活用事例

❷BIMを活かすためのツール紹介

❸DXレポートについて

❹建設業界におけるDX

参考URL

*1 https://www.apple.com/child-safety/pdf/CSAM_Detection_Technical_Summary.pdf

*2 https://www.apple.com/child-safety/