Google DeepMindが発表した学習モデル「RT-2」とは?その強みを解説

高性能なAIやロボットの開発において、欠かせないのが優れた学習モデルを用意することです。学習モデルの進化はロボット工学の進化とも直結している要素ですが、Google傘下の企業が新たに開発した「RT-2」は、高度なロボット開発を後押しする学習モデルとして関心が高まっています。

この記事では、Google DeepMindが開発した学習モデルであるRT-2について、その特徴や実用化で可能になることなどを解説します。

目次:

- Google DeepMindについて

- ロボット開発が抱える課題

- 「RT-2(Robotics Transformer 2)」とは

- RT-2の実用化で可能になること

Google DeepMindについて

Google DeepMindは、2014年にAlphabet社の傘下にあったイギリスのDeepMind社を買収し、Google Brain Teamと統合することで誕生したGoogleの子会社です*1。

AIの開発、そしてAGI(Artificial General Inteligence、汎用人工知能)の実現に向けた活動を主軸としながら、量子コンピューティングや最新の学習モデル開発に取り組んでいます。

GoogleはOpenAIのChatGPTやMicrosoftのBing AIといったチャットボットAIの登場に合わせ、自社オリジナルのチャットボットAI「Bard」を公開するなど、AIシェアの獲得競争にも積極的に参入しています。

Google DeepMindもまたGoogleのAI開発競争力を支える上で重要な役割を果たしており、今後も次々と新しいサービス開発を進めていくことが期待できるでしょう。

ロボット開発が抱える課題

基本的に、AIの開発や機械学習はソフトウェアの分野に注目が集まりがちですが、それをどのようにハードウェアへ実装するかについての取り組みも別個に進める必要があります。

ロボット技術はAIの登場に伴い、ここ10年ほどで飛躍的な進化を遂げている最中ですが、依然として課題は潜在しているのが現状です。

現在のロボット開発において大きなハードルの一つとなっているのが、ロボットにソフト面での柔軟性を持たせることが難しい問題です。

IT革命に伴いロボットの活用は製造業などで進んできましたが、いずれのロボットも基本的には事前に与えられた命令通りにしか行動ができない点です。ものすごいスピードで自動車の組み立てができるロボットでも、人の顔を見分けたり、パーツの種類を自分で判断して分類したりといったシンプルな行動も実行ができないケースは珍しくありません。

人間であれば、上記のようなタスクが発生した際、自然言語で作業員に指示を下し、その通りに作業を進めてもらえるよう方向づけてやるだけですぐに新しい作業も進められるようになります。

一方でロボットの場合、例えハードウェアの性能上は容易に可能なタスクであっても、上述のようにある程度判断力が問われる業務ができるようになるためには、プログラムを新しく書き直したり、多くの時間をかけて学習を行ったりする必要が出てくるのです。

ロボットのさらなるハイテク化を推進する上では、何らかの方法でロボットのソフトウェアに柔軟性を持たせ、汎用に使いこなせる環境を整備する必要があります。

「RT-2(Robotics Transformer 2)」とは

上記のような問題を解決するため、Google DeepMindが2023年7月に発表したのが「RT-2(Robotics Transformer 2)」と呼ばれる学習モデルです*2。VLA(Visual Language Action)モデルの一種と呼ばれるこの学習モデルは、インターネット上のテキストデータや画像データを使い、ロボットを訓練することができます。

RT-2の仕組み

RT-2は、Google DeepMindのオフィスにあるキッチンで稼働している13台のロボットが、17ヶ月もの時間をかけて収集したデータをもとに訓練を行った前身の「RT-1」をベースに開発されたモデルです*3。

基本的な構造はChatGPTなどにも採用されている言語モデルと同様で、インターネット上にあるテキストデータや画像データ、そして標準で備えている訓練データを参考にしながら、ロボットを直接制御することができます。

自然言語でロボットに命令を送り、例えそのロボットがその命令に応えられる機能を備えていなくとも、ネット上の情報を頼りに命令を実行するためのデータを集め、指示通りに動作するような使い方が可能です。

ChatGPTが命令通りにテキストを出力してくれるように、RT-2を導入したロボットは命令通りにタスクをこなせるようになります。

RT-2のパフォーマンス

RT-2の研究チームは公開に先駆けてテストを繰り返し実行しており、ロボットが見たことのない物体やシナリオに対して適切に動作できるかどうかの評価を進めてきました。

その結果、従来のRT-1モデルなどと比べてRT-2は飛躍的に高い汎用性を獲得することに成功しており、完全に見たことのないタスクの成功率をRT-1の32%から62%にまで高めることに成功しています*4。

現状では未知のタスクを完全に実行してしまうほどのパフォーマンスには達していないものの、今後学習モデルのアップデートが進めばより高いタスク成功率を実現することも可能でしょう。

また、人間に新しいタスクを実行させるにしても、100%の確率で担当者が確実に遂行できるとは限らないものです。ある程度のエラーのリスクは常に潜在していると考えると、RT-2のレベルは決して低くない領域に達していると言えるでしょう。

RT-2の実用化で可能になること

RT-2、あるいはその後継モデルが本格的にロボット活用の現場で導入されるようになれば、ロボットの生産性は飛躍的に高まることが期待できます。

単純に作業効率の改善をロボットが自律的に行えるようになったり、一台のロボットを多様なタスクに転用することが出来たりするようになるので、タスクごとにロボットを新たに購入するようなコストの問題も回避できるでしょう。

また、少ないロボットで多くの業務を担えるようになれば、省スペースで多くの生産業務を実施することも可能になるはずです。さらなる工場のスマート化を進める上で、今後RT-2のような学習モデルの存在は欠かせません。

まとめ

この記事では、RT-2の概要やどのような導入効果が期待できるのかについて解説しました。RT-2はまだ実用レベルでの導入は進んでいないものの、ロボットのスマート活用を推進する上では欠かせない学習モデルであることは間違いありません。

今後改善が進み、より高い精度で未知のタスクに対応できるようになれば、急速なロボット技術の発展や、製造業界をはじめとするロボット活用が盛んな領域において、高度な生産性向上が進むと期待できます。

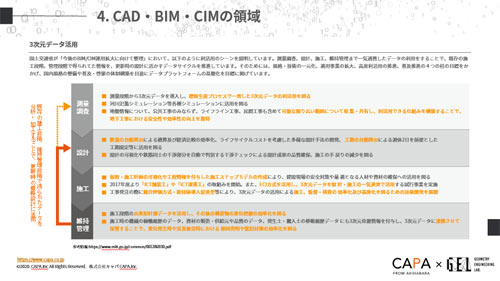

建設・土木業界向け 5分でわかるCAD・BIM・CIMの ホワイトペーパー配布中!

CAD・BIM・CIMの

❶データ活用方法

❷主要ソフトウェア

❸カスタマイズ

❹プログラミング

についてまとめたホワイトペーパーを配布中

出典:

*1 ITmedia NEWS「Google、AGIのある未来を目指しGoogle DeepMind立ち上げ」

https://www.itmedia.co.jp/news/articles/2304/21/news086.html

*2 ITmedia NEWS「Google DeepMind、ロボットの行動を改善する新VLAモデル「RT-2」発表」

https://www.itmedia.co.jp/news/articles/2307/29/news059.html

*3 ASCII.jp「グーグル DeepMind、ロボット向けAI「RT-2」開発」

https://ascii.jp/elem/000/004/147/4147707/

*4 上に同じ